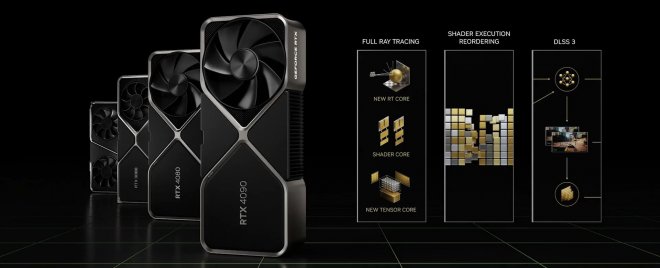

Az Nvidia hivatalosan is leleplezte az RTX 4090 és RTX 4080 kártyákat

Az Nvidia vezérigazgatója, Jensen Huang hivatalosan is leleplezte a következő generációs Ada Lovelace GPU-széria első modelljeit. Összesen három kártyáról rántották le a leplet, amelyek a következők: RTX 4090, RTX 4080 16GB és RTX 4080 12GB.

A flagship Nvidia Ada Lovelace GPU 76 milliárd tranzisztort ölel magába, és a TSMC 4N gyártási technológiával készül. Az új architektúra az RT magok harmadik generációját, illetve a Tensor magok negyedik generációját is elhozza, ráadásul a cég megerősítette az Ada Lovelace DLSS 3 támogatását is.

Az RTX 4090 alapja az AD102-300 GPU lesz, melyre 16384 CUDA mag és 2520 MHz boost órajel lesz jellemző. 24 GB GDDR6X memória kerül majd rá, melynek maximális sávszélessége az 1 TB/s-ot is elérheti. Az új kártya legalább 100 W-tal több energiát igényel majd az RTX 3090 Ti-hez képest, miközben a várható TDP 450 W körül lesz. A cég szerint teljesítményben 2-4X gyorsabb termékről beszélünk az eddigi csúcstartó, a 3090 Ti-hez képest. A legnagyobb különbség RT és a DLSS 3 használata esetén figyelhető majd meg. Ez a modell október 12-én válik majd elérhetővé, és 1599 dollárt kell majd fizetni érte.

A vállalat partnereitől is folyamatosan érkeznek a bejelentések. A ZOTAC, az Inno3D, a Colorful, a Palit, a Gainward, a Gigabyte, az MSI és az ASUS terméke is bemutatkozott, viszont egyáltalán nem meglepő módon az EVGA nincs ezek között.

A fenti kártyán felül Jensen Huang az RTX 4080-as szériáról is lerántotta a leplet. Két kártya várható, amelyek a memória méretében és GPU-specifikációkban térnek majd el. A 16 GB-os modellt az alábbi specifikációk jellemzik majd: AD103 GPU, 9728 CUDA mag, 16 GB GDDR6X memória (22,5 Gbps) és 320 W TDP. A kártya novemberben érkezik, és 1199 dollárt kérnek érte.

Az eredetileg RTX 4070-nek tervezett kártyát pedig RTX 4080 12 GB néven jelentették be. Erre az SKU-ra az alábbiak érvényesek: AD104 GPU, 7680 CUDA mag, 12 GB GDDR6X memória és 285 W TDP. A kártya ára 899 dollár lesz.

Na akkor nálunk ez olyan 1.5 millió lesz kb!

Még most vicces vissza gondolni 2008-ban egy elég erős HD 4850 199 dollárért rajtolt, és az elég tiszteséges teljesítményt produkált az áráért.

Most meg majd annak lehet örülni ha a RTX 4070 699 dollárért fog piacra kerülni....?

És lesz benne 6000 cuda mag jó indulattal 128 biten.... Joke XD

na igen, ez igaz! :D

"A vállalat partnereitől is folyamatosan érkeznek a bejelentések. A ZOTAC, az Inno3D, a Colorful, a Palit, a Ginaward, a Gigabyte, az MSI és az ASUS terméke is bemutatkozott"

Tehát Gainward. :D

persze még mindig jobb a DLSS 2.0 de az FSR 2.0 is eléggé bejött a képbe, viszont az RT vel tényleg nem tud nagyon mit kezdeni az AMD egyelőre, abban jóval jobb az nVidia, de azt is el kell mondani hogy 1-2 játékot leszámítva még az RT sem egy kiforrott dolog, persze az idő múlásával ez változni fog, mindenesetre én nagyon várom mit hoz az AMD, persze voltak már Leek-ek (mint mindenről manapság) de várjuk ki a hivatalost.

Az FSR 2 jó dolog, de nagyon messze van mind technológiában, mind képminőségben a DLSS -től, ráadásul játékfüggő, hogy mennyire működik jól vizuális szempontból. A DLSS 3 pedig olyan új funkciókat hoz, amit abszolúte senki más.

Ami gond: A 4080 jócskán vissza van véve magok számában. Ismét látszik, hogy ezek az Ada magok sem valami jól skálázhatóak.

Teljesítmény predikciók: 4K MAX, DLSS OFF, RT OFF

RTX 4090 - 170% - 1599 USD

RTX 4080 - 140% - 1199 USD

RTX 4080 12G - 115% - 899 USD

RTX 3090 Ti - 106% - 1050 USD

RTX 3090 - 100% . 950 USD

RX 6950 XT - 98% - 980 USD

RDNA3: Szerintem simán fogja hozni a 4090 teljesítményét a csúcs RX 7000-es kártya. Persze sokkal kevesebb fogyasztással. Egyedül a DLSS 3 ill. RT teljesítmény lesz idén is az achilles sarka a kártyáknak, de ha az RX 7900 XT RT + FSR 3.0-val hozza egy RTX 4080 teljesítményét, sima raszterben pedig a 4090-ét, akkor 1200 dollárért best-buy lehet. Ne felejtse el senki, hogy az NV-nek nagyon drága mulatság az Ada kártyák gyártása. Az RDNA3 lényegesen olcsóbb lesz az AMD-nek gyártani.

A DLSS 3 az eddigiek alapján eléggé jónak igérkezik

Hazudnék, ha azt írnám, hogy nem kellene 4000-es modell. Szívesen vennék.

Ellenben mióta pártunk és qurmányunk elbalfékeskedett nettó 6 évet Paks-2 építésével,

így fizetheted az emelt árat bizonyos fogyasztás felett (~244 kW/h) nos az a helyzet, hogy

egy 4080 simán berágja a limitet ha nem feszelem alul (ott van még a G-besorolású monitor hozzá) de így meg akkor olyan, mintha 4060/70-et vettem volna lol.

Remélem érthető mit akartam kinyögni ebből az egészből...a fogyasztást ennél a kártyánál figyelembe kell venni, főleg mikor van hozzá egy b*szó monitor. Tudom, tudom, a monitor fényereje és frekvenciája is állítható... nincs napelemed/mobil atomreaktorod/antianyag-reaktorod, akkor bizony lehetnek számlák. Lehet visszavenni mindenből.

És jönnek a kérdések:

Van értelme félelemben kockulni?

Muszáj mindenkit átszuszakolni a konzolhoz?

Tényleg ez lesz a sorsunk? A PC-géming csak a felső-rétegeknek adatik meg?

Egyébként meglepett hogy pont te írod ezt, mert korábban mindent "alulfeszeltél" és hírhedt fogyasztás-huszár voltál.

Értettem a lényeget.

Nyomja befelé a távhő a meleget a lakásba, ezért télen is forrósodik a vas mint a Merkúr felszíne emiatt feszeled alul. Nem pedig a fogyasztás miatt. Tiszta sor. 😉😊😆

Amúgy a gyári beállítsokkal kapott hőfok, és a saját mókolás által történt 'alulfeszelés' közti 1-3 C-fok nem oszt nem szoroz. Ha csak nem abszolút pormentes helységben van a gépházad, és leveszed az oldalát, esetleg ha nem egyedi professzionális vízhűtés van a kártyán, az a pár volt lecsipkedés nem fogja évekre megnövelni az élettartatomot, de te tudod. A kevesebb volt,kevesebb amper, kevesebb vatt nagyobb hatással van a fogyasztásra mint a hőfokra. Mivel a többi alkatrész szintén melegszik a zárt gépházon belül. Ha csak nem feszeled alul a többi hardvert is lol. Inkább köttesd át a rádiátort hőmennyiségszabályzósra. 😉😅🤣

(csak vicceltem ne vedd komolyan, tudom hogy át van kötve)

Annyi, hogy a 3090Ti-ból az összes 450W-os már most is. De a 3x8 pines 3080Ti-k is kitolhatóak oda.

Szóval itt már a komolyabb verziók 500 felett lesznek bőven szerintem.

Az csak a bejelentés dátuma lesz sajnos. Az Október 12 is még távolinak érződik egyenlőre.

@enslaved: Sokat én sem nyomom mostanában. De azért a 4K 120Hz-ra el fog férni a 4090. Bár a 3090Ti sem rossz azt azért hozzáteszem. Ezek elég jól húzhatóak is. Annak ellenére, hogy most egy új Gainward Phatom van a gépben. Ennek a legjobb a hűtése szerintem.- Vizesnél is laza 20 fokkal hűvősebb a memória. Megáll 74 fokon ennél a típúsnál max terhelésen 450W-on. A 4090 nem tudom ilyen lesz-e ebből a szempontból. Vagy Ott is csak a 90TI kiváltsága lesz majd bő 1 év múlva a jobb hűtés és a jobb tuning.

A szerencse mondjuk, hogy az összes 3090Ti új hűtést kapott. Így mindegyik jobb lett. De a Gainwardnál jobbat még nem találtam.

Annyira jó vétel lenne a 4080 16gb ha normalizálodna az árak, de nem hinném. Meg akkor most csak az új kártyák támogasák majd a DLSS 3-mat? vagy csak én nem értem.

Az európai árak:

RTX 4090 ab 1.949,00 €

RTX 4080 (16GB) ab 1.469,00 €

RTX 4080 (12GB) ab 1.099,00 €

Azért ez beszorozva 400-al(minimum) Ezt az rápakolva egész kellemes számok jönnek ki.

Ez így van erre már énis gondoltam ✔️

Az is szép lenne, ha feleannyi téglából ugyanakkora és ugyanolyan biztonságos házat lehetne építeni, vagy az, ha egy fél tank benzinnel is ugyanolyan messzire menne az autód ugyanolyan sebességgel.

Ha csak egy célhardverre kell fejleszteni, akkor elég sok kakaót ki lehet préselni belőle. Lásd az Apple, vagy a konzolok esetét. Mindezek ellenére csoda nem létezik a világon, minden egyes grafikai műveletnek teljesítménybeli ára és végeredményben fizikai korlátai vannak (memória mennyisége, órajel, időzítés, buszsebesség, stb...). A PC grafikának mindaddig lesz egy bizonyos fokú overhead -je, amíg nem érünk el egy olyan állapotba, hogy gyakorlatilag csak egy célhardver lesz. A DX12 és a Vulkan sokat segít egyébként, a korábbi 20 - 30% -os overhead mára már jóval kevesebb.

Igen, csak éppen azokban az időkben nem a klasszikus chipek fizikai korlátainak határán táncoltunk.

Ezt most tényleg ne vedd rossz néven, de akkor az említett családtag miért nem dolgozik chipgyártástechnológiai mérnökként egy chipgyártónál? Illetve milyen elektronikában jártas?

Fontos a sok VRAM és RT-teljesítmény. Azt várom, hogy a 3090 menjen még lejjebb használtan. Úgy se most vennék, kíváncsi leszek, hogy jövő év elejére milyen áron lesz aprón. Jelenleg a legolcsóbb használt 3090 - ami talán még nem kelt el, mert a napokban tették fel - az 330k volt.

Ha sok lesz számomra 2023-ban is (nem tudni mennyi pénzem lesz akkor, így semmit nem tudok mondani), akkor kompromisszummal lehet lesz egy 3060 12GB, ami már most 100k-ért megy kb.

De munkára nem veszünk AMD-t, mert a programok nem szeretik.

Úgy látszik ez alapján a 4090 a legjobbnak, 400 dollár a felár a X80-hoz képest de 60%-al több cuda mag van benne.

Azért kíváncsi leszek ahol nincs DLSS és Ray Tracing, ott mennyivel is tudja majd megelőzni a régebbi generációt.

Meg a 400 dolláros dollár/forint árfolyam és a 27% áfa végett itthon nem lesz ez nagyon népszerű.

Bár nem is a hazai piacra szánja az Nvdia.

biztos kemény kártyák lesznek, a mostaniak is azok... de azért ezzel az árazással kicsit tökön szúrták magukat... :/ bár a bányászoknak aztán tök mind1 mi mennyibe kerül úgyis megveszik majd :D

Rámegy még a kereskedő haszna és a világbajnok áfa és nem lesz ez olcsó mulattság.

700-800E forint lehet itthon jó indulattal.

Egyébként ritka undormány húzás 80-as néven kiadni egy 70-est, de valszeg nem hülyék dolgoznak a marketing osztályon, biztos bejön belőle pár ezer $.

Nagyot akart mondani a kis sunyi húzott szemű, de majd ha a kutya nem veszi launch után már 2 hónappal ennyiért, lehet menni magyarázkodni. Az meg nem opció, hogyha nem veszik ennyiért akkor nem gyártjuk tovább. 😁

A 4K-t is röhögve fogják futtatni 144 hz-es monitoron.

Én egy 4K oled monitor társaságában fogom max megvenni,ha egyszer megjelenik itthon is.