Az Nvidia vezérigazgatója szerint a Radeon VII vacak és semmi újat nem mutat

Az Nvidia vezérigazgatója, Jensen Huang egy elég erős kijelentést tett az AMD által leleplezett Radeon VII-tel kapcsolatban.

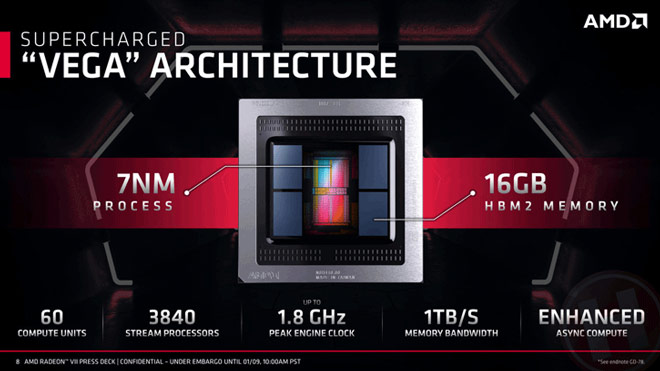

A PCWorld-nek adott interjú során Huang elmondta, hogy szerinte az AMD új kártyájának teljesítménye rossz, és még újdonságot sem mutat. Egyáltalán nem sikerült a terméknek lenyűgöznie őt, majd hozzátette, hogy „nincs ray tracing és AI sem. Mindössze egy HBM memóriával ellátott 7 nm-es kártyáról van szó, amely alig veszi fel a versenyt az RTX 2080-nal. És ha aktiváljuk a DLSS-t, akkor letiporjuk, és ha a ray tracinget kapcsoljuk be, akkor szintén letiporjuk.”

Jensen Huang elég furcsának tartja a Radeon VII bejelentését, és szerinte biztosan csak a reggel folyamán álltak elő az ötlettel. Elég komoly szavak ezek egy vezérigazgatótól egy olyan termékről, amely még nincs is a piacon, ugyanis a Radeon VII csak február 7-én válik majd elérhetővé. A megjelenést követően pedig a különálló tesztekből fog kiderülni, mire is képes az AMD új kártyája, és tényleg megszorongatja-e majd az RTX 2080-at.

Az nvidia AI -a csak bizonyos grafikai eljárások gyorsításában segít.

"Pedig AI -al mindenhol találkozol nap mint nap." - Értem én, hogy a hsz-em ezen része fogott meg a legjobban, amibe akár bele is mehetnénk, de sokkal érdekesebb azon része, ami a cikkre reflektál!

Nem kell érteni, vagy egyetérteni azzal amit írtam! Ez a hsz-em már egy éves, és láss csodát most egy évvel később egy másik cikk alatt szintén vitába keveredtünk, amely cikk pontosan ezt a kommentemet erősíti meg!

Had idézzek "Az Nvidia Ampere széria várhatóan az év második felében érkezik, és valószínűleg a konkurencia nyomása miatt az Nvidia a vártnál jóval erősebb termékeket készül piacra dobni." Most akkor hogy is van? "És ha aktiváljuk a DLSS-t, akkor letiporjuk, és ha a ray tracinget kapcsoljuk be, akkor szintén letiporjuk." De ha mégsem akkor valami még erősebbel kell előállni, de félek azért az AMD-nek is lesz némi beleszólása! 😀

Itt tényleg érdekelnének az aggályaid és meglátásaid a témával kapcsolatban.

Nem kell érteni, vagy egyetérteni azzal amit írtam! Ez a hsz-em már egy éves, és láss csodát most egy évvel később egy másik cikk alatt szintén vitába keveredtünk, amely cikk pontosan ezt a kommentemet erősíti meg!

Azon részére, ami a cikkre reflektál nem írtam semmit, mert pár kommenttel korábban már megtettem másnak. Azon nem vitatkoznék, hogy egy ilyen kijelentés valóban erős és nem mondhatni még véletlenül sem profinak, de afelől nem volt kétségem, hogy az nvidia bármennyire is félt volna az AMD -től. Jelenleg az nvidia testhosszal jár az aMD előtt GPU technológiában és támogatásban egyaránt. Az AMD is volt már ebben a pozícióban, de öt éve nem tud fellépni az abszolút csúcs kategóriába. Ez ebben a szegmensben presztizsharc és marketingerő. Annak idején egymásra licitálva jöttek az újabb VGA -k, a trónfosztás mindig borítékolható volt. Manapság már nem, mert a fejlesztési költségek sokkal magasabbak és a lobbi is afelé húz, aki nagyobb hal. Az AMD is fejleszthetett volna például DXR képes GPU -t, de nem tette. Emellett a teljesítményt sem tudta növelni. Az alsóbb szegmensekben ezzel szemben kiváló termékeket hozott nagyon jó ár / érték aránnyal. És ezzel csak arra akarnék rámutatni, hogy az nvidiának nem kell leigáznia az AMD -t és nincs is beszarva tőle.

A fejlesztési költségekre visszatérve hozzákapcsolnám azt, amit a másik cikknél írtál, mégpedig: "Mert ha tudnak sokkal jobbat, de csak azért csinálják meg mert a konkurencia... az több kérdést vet fel mint választ ad! Ezek szerint ha lehúzhatnak rólad nyolc réteg bőrt, akkor mért érnék be csak hárommal?!"

Az nvidia nem ücsörög három - négy új teljesen kifejlesztett szérián arra várva, hogy mit lép az AMD, hogy majd aztán jól megmutatják.

Legyen beleszólása, az csak jót tesz a piacnak. Jelenleg viszont nem nagyon mutatnak arra a jelek, hogy ezt meg tudják lépni.

Hát azzal legfeljebb saját magukat tapossák el.

Minőségben viszont elég gáz, sokszor rengeteg glimmeringet produkál. Én továbbra is az MSAA mellett vagyok.

Xoki, azt kell mondjam kezdesz nagyon ráérezni a hírezésre, legalábbis arra a részére, ami clickbaitet és ezáltal reklámbevételt generál. Remélem a sok intelligens hozzászóló legalább a gepigeny.hu -n kikapcsolja az ad.blockert.

1. Senkit nem érdekel mint mond Huang kutyazabáló géza, nem tudom hogy miért gondolja hogy érdekel akárkit is a véleménye, biztos nagyon sokat és keményen dolgozott az emberiségért (no offenz)

2. Nyílvánvalóan nem fogja pozitívan bereklámozni a rivalitás legújabb termékét

3. Mondjuk ki a szomorú igazságot az nvidia már nem jobb mint az amd. Azok az idök már elmúltak. Akinek ez 2019-ben meglepetést okoz az elég szomorú.

4. Ez ma max csak pár mainstream youtubernek van mire erre váltunk már ennél olcsóbb és jobb kártyák lesznek piacon

No offenz? 😂 Az egész kommented tocsog a habzó véres nyáltól (és még rasszista is).

"3. Mondjuk ki a szomorú igazságot az nvidia már nem jobb mint az amd. Azok az idök már elmúltak. Akinek ez 2019-ben meglepetést okoz az elég szomorú."

Végül is csak az utóbbi négy évben nem tudott az AMD teljesítményben az nvidia fölé kerekedni. De hagyjuk is inkább, te biztosan nagyon jól meg tudod magyarázni.

Nem vagyok elfogult (egyszerre használok GTX 1080 -at, RX 580 -at és HD 7870 -et) és szerintem a tényeket figyelmen kívül hagyó kijelentések az őket leírókat jellemzik igazán.

Na tessék, erre én is megmondó lettem 😶

A régi játékokban sík felületen szimplán tükrözve lerenderelték a képet másodjára (kvázi portál).

Ray tracinggel bármilyen felületen lehet valós idejű tükröződést csinálni, mert az a fény útját szimulálja.

Azzal, hogy a RT most így kerül bevezetésre én sem értek egyet teljesen, de valamilyen irányba tényleg el kell indulni fejlődés terén.

Igazából én sem értem ezt a döntést, a 2060 már simán kaphatott volna 8 GB memóriát, de akkor drágább is lenne.

Nah erről van szó, azért akad pár játék aminek jócskán kell a Vram, itt az a baj ameddig a játékok 4 maggal is elfognak futni addig nem (lesz//) szükséges + 6giga vram-nál több mert minek?

Egy jó példa a GTX 1060 3GB, olcsó akinek meg kell a hosszabb táv az megy vegye meg a 6GB-s verziót..

Call of duty va ha jól emlékszem egyik gépigényes kolega tett be egy képet hogy a 1080ti jénél full hd ba mindrn kimaxolva 10gb ot evett vramból neki tudom is a kolega nevét csak fogalmam sincs hogy írja most meg nem keresem 😃

Na de nem ertek hozzá. Biztos okkal van 6 Gb benne.

Legalább egy 1080 vagy egy 1080ti-t vennék ha vennék az alá nem adok ha veszek VGA-t a jövőben,de nekem a játszás ilyen hullám völgyekben jön rám van mikor egy hétig ki sem tudnak robbantani a gép elöl van mikor meg 1-2 hétig be sincs kapcsolva a gépem... tehát ezért nem vettem még komolyabb konfigot... mert szerencsére megtehetném de minek ha nem játszok olyan komoly szinten,de a másik ok hogy nincs sokszor kivel... :/

Másik lehetőség: simán veszek egy Ryzen 5öst 80k körül (tippre annyi lesz, persze ár még nincs) és ugyanott vagyok valószínűleg, mert régi alaplapomba bele fog menni. Hűtése, hőfokai, fogyasztása sokkal jobb lesz a 7 nm miatt.

Alaplapot persze így is lehet kell majd cserélnem, mert sajnos csak 2800 Mhz CL 18 on fut a 16 giga RAMom a 4 modul miatt, gyorsabban nem támogatja, csak 2 modullal a 8 gigát. Azért ez is vicc.

Persze ha az új generáció nem lesz olyan memória sebeség érzékeny, mint a régi, akkor lehet hagyom így, de azért ez zavar.