Az AMD elárulta az RX 9070-es kártyák árát és megjelenési dátumát

Az AMD hivatalosan az idei CES során jelentette be az RDNA 4 architektúrán alapuló RX 9070 szériás grafikus kártyákat, azonban még csak most fedték fel a legfontosabb részleteket, beleértve az árazást és a pontos megjelenési dátumot.

Korábban már lehullott a lepel az RX 9070 XT és RX 9070 specifikációiról, melyek szerint az új GPU-k akár 64 Compute Unit / 4096 Stream Processzorral rendelkeznek majd. Az AMD szerencsére 16 GB (20 Gbps) DDR6 memóriával látta el mindkét modellt, így a játékosoknak nem kell a memóriakorlátok elérésétől tartaniuk.

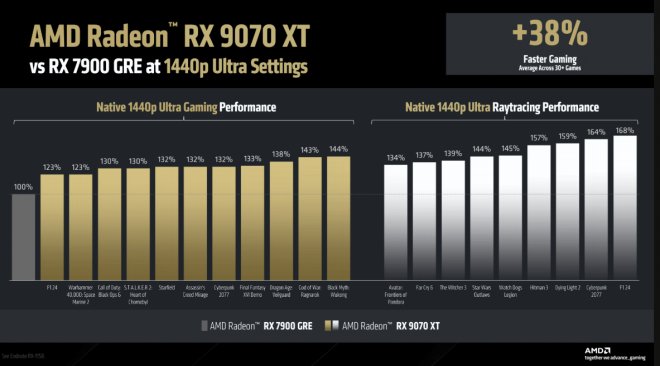

Harminc játék átlagteljesítménye alapján az RTX 3080-hoz viszonyítva az RTX 9070 állítólag 26%-kal gyorsabb. Az AMD az előző generációs RX 7900 GRE-hez viszonyítva is megmutatta, mekkora javulásra számíthatunk. Ezek lesznek az első olyan modellek, amelyek támogatni fogják az AMD FSR4 technológiáját.

Az RX 9070 XT és az RX 9070 március 6-án kerül majd a boltok polcaira. Előbbinek 599 dollár, míg az utóbbinak 549 dollár az ajánlott fogyasztói ára.

(Amugy ennyire gagyi dobozt/dizajnt a 2000es evek kozepe ota nem lattam, eleg nosztalgikus hatasa van 😆 )

Spoiler!

Van játék, amiben én is használok RT-t, mert rohadt jól néz ki (Spider Man 2), de ha nem futna normálisan natívan azzal, akkor csont nélkül kapcsolnám ki, és inkább legyen smooth a játékmenet, mint lássam a felhőkarcolók ablakaiban magam meg a környezetet mászás közben.

. Ahhoz képest az FG es a DLSS egy kis kompromisszum. Persze FG-t én is csak abban az esetben használok, ha nincs meg a fix 60FPs.

Én azt mondom, hogy a PC építés sosem lesz olcsó hobby, akkor már inkább NVIDIA. Ha valaki meg olcsón akar játszani az vegyen PS-t. Konkrétan fele árból közel 4070ti teljesítményt lehet vele elérni.

Abba meg ne menjünk bele, hogy miért futnak egyre szarabbul játékok, de így tippre lehet segítene az is, ha nem futószalagon határidőre gyártott szemetet fejlesztenének az emberek megfejéséért, meg nem bőrszín, nem, vallás és társai alapján alkalmaznának fejlesztőket, hogy meglegyenek a kvóták.

Ha valakinek tetszik a skálázás, nem zavarják a hibái, hát legyen, ő nézi, még az is lehet, hogy neki növeli a játékélményt, mert a kevésbé éles élekkel neki kellemesebb egy erdős rész vagy akármi. Viszont az FG, MFG olyan input lagot csinál, hogy hányok, bár nemtudom, lehet én vagyok rá annyira érzékeny, és nem tudom elviselni, hogy hiába tűnik folyamatosnak a kép szemre, érzésre mégsem az, mert hiába a szép szám, az input ugyan úgy fele, vagy negyed annyi FPS érzését adja. Elhiszem, ha ezt valaki nem érzi, mert máshoz szokott, de attól még így van.

tudom kit, miért érdekel. Mintha bármelyik játékos amúgy felfogná milyen típusú háttér számítások tömege megy végbe, amíg a kép meg nem jelenik. Az emberek meghallják, hogy AI és egyből az már csak rosszabb lehet meg nem valós kép, mondja az, aki a natív, de virtuális képre valós képként tekint. Persze van hova fejlődni mindig, de hasonlíts össze egy nativ vs dlss 4 összehasonlítást egy indiana jones RT vs non-RT összehasonlítással, megnézném melyikre mondanád, hogy látványosan csúnyább. Az FG most éli a második generációját, így nem tökéletes, de pont az input lag az ami mostanra nagyon jól ki lett javítva és független tesztek alapján is elhanyagolhatónak mondható.

Az, hogy most hogy jött ide a fejlesztők bőrszine és hogy rosszak a játékok, azt nem teljesen értem. Persze azzal egyet értek, hogy nem sok jo és jól optimalizalt játék jelenik meg, de ez most más fórum.

Szerintem nem egy moziban ülünk és én itt le is zárom.

is valós információból, de mondom kit érdekel miből jelenik meg, ha megjelenített kép jobb vagy hasonló nagyobb FPS-el. Azt kellene megérteni, hogy az erőforrás igény nő a játékoknál a hardver fejlődése viszont belassult és nem is hatékony az hogy 1000w videokártyákat gyártsanak. Szóval ellenkezhetünk, de így is úgy is e felé fog haladni a világ és ezt a GPU fejlesztő cégek is tudják, nem hiába nem a raster teljesítményben van már a verseny. Megjegyzem PSSR is sokat dobott a kép minőségen és úgy hogy kis hardver fejlődés mellett szebb képet is kaptunk es jobb frame ratet, pedig a raster teljesítmény nem sokat javult, tapasztalatból mondom.