Megjelenési dátumot kapott az AMD Fluid Motion Frames technológia

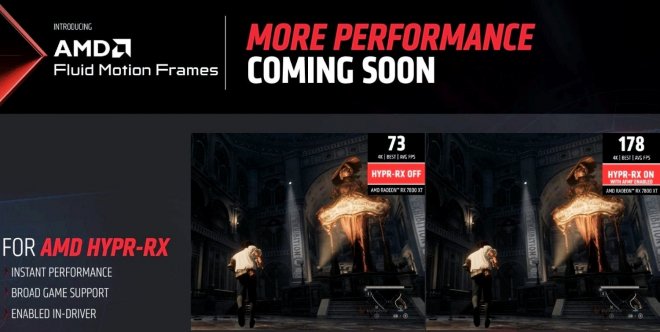

Január 24-e kiemelkedő nap lesz az AMD rajongói számára, ugyanis a vállalat ekkor fogja kiadni a 16 GB-os RX 7600 XT-t, illetve a Fluid Motion Frames, azaz az AMD Frame Generation technológiája is befut majd.

A technológia a HYPR-RX részeként érkezik, de különálló opcióként is elérhetővé kell válnia az illesztőprogramokban. Az AMD Fluid Motion Frames nem igényel játékfejlesztői támogatást, és zökkenőmentesen működik bármilyen implementáció nélkül. Természetesen ez azt jelenti, hogy csak AMD Radeon GPU-kkal használható, és nem támogatja mindegyik kártya.

Az AMD korábban már előállt a Fluid Motion Frames támogatással ellátott korai illesztőprogramokkal. A legutóbbi frissítéssel a Radeon 700M integrált széria, míg korábban az RX 6000 lett támogatott. A 600M (RDNA2) jelenleg nem támogatott. A Radeon Super Resolution (RSR) funkcióval együtt a játékosok lehetőséget kapnak a felskálázás és a képkocka generálás engedélyezésére. Ennek minden DirectX11-es és DirectX12-es játékban működnie kell.

Az AMD természetesen tisztában van vele, hogy komoly előnye van az Nvidiával szemben, hiszen ez a megoldás „minden” játékban működik, miközben a DLSS 3 + Frame Generationt külön implementálni kell a játékokba, és kizárólag RTX 40 GPU-kkal működik.

Az NVIDIA egyébként rendelkezik egy NIS (NVIDIA Image Scaling) nevű felskálázási technológiával, de ez egy egyszerű, AI technológia nélküli térbeli felskálázó. Amennyiben az NVIDIA piacra dobná az RSR versenytársát, az AFMF megjelenésével az AMD akkor is két lépéssel az Nvidia előtt lesz majd.

ha meg nem akkor marad az Nvidia.

😂😂😂

Fsr3 ból se lett semmi szinte, ebből se lesz.

Ki próbáltam béta verzióban, a dlss hez képest sehol nincs!

A legnagyobb probléma az, hogy egy idő után nem lehet tovább sűríteni a tranzisztorokat, az adatok feldolgozásában pedig nem minden esetben lehet párhuzamosításra építeni, tehát a minél több mag sem lesz lineárisan hatékonyabb. A grafikai részletesség emeléséhez szükséges hardverigény növekedése pedig nem lineáris, hanem exponenciális. A 90 -es és 00 -es években a hardverek fejlődése sokkal gyorsabb volt, mint manapság, évente történt generációváltás. A 10 -es évek közepétől már két év volt a kifutás és a teljesítményugrás küszöbe, jelenleg pedig sanszos, hogy ez kitolódik a harmadik évbe. A hardverek teljesítménye pedig nem adott fogyasztási határon belül nő, hanem szinte már követi azt, akár csak a hőtermelés. Jó példa erre az AMD legújabb Ryzen architektúrája. Az efficience magok a nagy teljesítményű magok komplett másai, de a mérnökök szűkebbre vették a méretet (nem a gyártástechnológiáét, hanem a huzalozás és a tranzisztorok közötti üres teret komprimálták), ami által ugyanaz a mag csak alacsonyabb órajelen működik, mert sokkal kisebb felületen kell leadnia a termelődő hőmennyiséget (máskülönben túlmelegedne és károsodna). Ez egy nagyon pozitív megközelítés, mert nem kell külön tervezni más felépítésű magokra, de jól mutatja, hogy hol a probléma a szilícium félvezető, fotolitográfián alapuló tranzisztoros chipek esetén.

Kitérve az optimalizálásra, igen, ez is szenved a jelenlegi játékpiacon, de közel sem annyira, mint azt sokan hangoztatják. Egy részről a legtöbbeknek fogalma sincs arról, hogy az optimalizálás valójában mi és hogyan zajlik, más részről azt gondolják, hogy az varázspálcaként működik és ugyanolyan grafikai részletesség mellett sokkal nagyobb teljesítményt hoz. Léteznek gyengén megírt kódok, slendrián szkriptek, ahogy mesterségesen generált megnövelt gépigény is, de a legnagyobb teljesítményt a grafikai szint változtatásával lehet elérni.

Pontosan ezt írtam le: "A grafikai részletesség emeléséhez szükséges hardverigény növekedése pedig nem lineáris, hanem exponenciális."

10% grafikai fejlődéshez 10^2 = 100% hardvertöbblet szükséges.

A lumen és különösen a nanite nagyon fontos és üdvözlendő fejlesztések. A nanite -re én személy szerint évek óta várok, nagyon örülök neki, hogy végre jön egy olyan rendszer, ami pontot tesz a klasszikus LOD korszak végére.

10% grafikai fejlődéshez 10^2 = 100% hardvertöbblet szükséges.

Alapvetően problémás ez a 10% -os mérce, hiszen mivel méred le a dolgot? Végeredményben a látványról van szó, az az, amit a legtöbben megtapasztalnak egy játékból és nem a háttérben zajló folyamatokat.

Leegyszerűsítve a dolgot ha visszanézünk a 3D gyorsított grafika kezdeti idejébe, a kilencvenes évek végétől a kétezres évek közepéig. Akkoriban ha egy játék 200 polygonból álló modelleket használt és ezt összehasonlítottad egy 300 polygont használóval, akkor piszok nagy különbséget láttál. Ha egy 1.000 vs 1.100 -as modellt hasonlítasz össze már lényegesen kisebb a különbség. Minél részletesebb a grafika annál több erőforrás kell ahhoz, hogy ugyanakkora egységnyi fejlődést érj el, mint az előző generációban és ezt nem követi a hardverek fejlődése.

A mai időkben eleve eljutottunk egy olyan pontra, ahol a fejlődés szemléletmódváltást is igényel, illetve sokat számít az egyéni preferencia, a játék stilisztikája, a digitális művészek kompetenciája. Nagyon leszűkítve ugyanolyan részletességű assetekkel és textúrákkal ugyanolyan fejlesztői környezetben lehet egy közepes kinézetű játékot kreálni, vagy egy csodaszépet úgy ,hogy mindkettőnek ugyanolyan magas a hardverigénye. Ha összehasonlítasz egy 2015 -ös húzócímet egy 2023 -assal és nem a technológiai oldalt, hanem pusztán a grafikát figyeled (legjobb esetben laikus szemmel), akkor apróságokon kívül nem sok különbséget találsz, a 2023 -asnak viszont nem lineárisan nő a számításigénye, hanem sokkal intenzívebben.

De jó példa mondjuk a Killzone 2 és a Killzone Shadowfall is, régi de teljesen jól mutatja azt, amiról beszélek. Egymás mellé téve a kettőt a grafika minőségének emelkedése nem lenne 100% -os, de induljunk ki ebből, tehát kétszer olyan szép a játék, lineárisan emelkedik. A render target az előbbi esetén 720p (912.600 pixel) utóbbinál 1080p (2.073.600), ami ugyancsak közel lineáris. Ha a textúrák felbontását vesszük elő, egy vizuálisan kétszeres részletességű textúra nem kétszer annyi pixelt tartalmaz, hanem négyszer annyit. A Killzone 2 512x512 -es textúrákkal dolgozik (zömében), ami 271.441 pixel, szemben a Shadow Fall minimum 1024x1024 -es textúráival, ami már 1.048.576 pixel, de a játék sok helyen használ 4096x4096 -os textúrákat is, amivel már 16.777.216 pixelnél járunk. A karakterek a Killzone 2 esetén átlagosan 10.000 polygonból épülnek fel, a Shadow Fall -ban 40.000 -ből. Előbbi egy 230GFLOPS teljesítményű konzolon jelent meg, utóbbi egy 1.8 TFLOPS teljesítményűn, ami 780% -os növekedés. Ez egy nagyon leszűkített dolog, ennél jóval bonyolultabb az egész, de pusztán ezek a számok is jól szemléltetik azt, amire gondolok.

Remélem így érthetőbbé vált, hogy miért használom az exponenciális kifejezést 😃 .

U.i.: Annak idején a 4k megjelenítő felbontás megjelenésével sokan nem igazán tudták megérteni, hogy a váltás itt sem lineárisan 1 -> 2, mint a HD Ready és a fHD esetén volt, hanem 1 -> 4. Arról nem is beszélve, hogy mindenre elkezdték használni a 4k kifejezést, köztük a textúra méretekre is, aminek az ég világon semmi értelme.

És még csoda, hogy sokszor úgy érzem, én egy ufó vagyok és nem tudom mit keresek ezen a bolygón. :D

Hanem az orbitális butításról.

A felskálázó technológiát már az elejétől beépíthették volna alapvetőként a struktúrába, nem pedig valami extra fjúcsörként villogtatni.

Mindezt úgy, hogy a legtöbb kész játék kb. ugyanazokból az assetekből, pakkokból készül, ugyanazon alap engine-en mint 6-8 évvel ezelőtt.

Nem kellett volna a pánik közepette ennyire ráállni a még használhatatlan új technológiák fércműves felhasználására, csak hogy ne az látszódjon, pang az iparág és kifogytak a kreatívitásból, mint hollywood.

Az UE4-et elég lett volna max. QHD szintig csont tisztára nyalni (vagy 2k-ra) és még jobban optimalizálni a komponensekhez.

Ehelyett HDR, 4k, RTX, DLSS, FSR, meg minden szarsággal etetik az embereket, hogy picit szemet vakuzzanak a látvánnyal legerősebb hardvereken is 20-30fps-el egekig szökő késleltetéssel.

Egy össze vissza csapongó sárral tapasztott kártyavárra épül az elmúlt 6-7 év játék és komponens gyártó ipara.

És az a bizonyos lufi most már egyre többször pukkan.

Szemfényvesztés az egész.

Amikor először megjelent, akkor még azt hittem ez egy jó dolog lesz. Hogy a játékipar azokat is így tudja majd becsalni pénzzel, akik amúgy nem rendelkeznek még elég jó videókártyával, de addig is kompromisszumokkal tolhatják a játékokat amiket így meg is vesznek.

De hogy már a játékok eleve úgy készülnek el, hogy lassan nem opció a felskálázó, hanem anélkül egy 1 millás kártyával se tudsz 60fps-t elérni kamu 2k-n...

Ahogy a filmben mondták. "Itt mindenki hülye?"

És itt a bizonyíték ezt már máshol is kifejtettem ott a Mátrix 2 vagy már talán 3 éves techdemoja ami mutatja hogy milyen játékok keszülhetnének ha bárkit is érdekelne még a játék fejlesztés. Amúgy kövezzetek meg de ott van a CS2. Oké nincsenek nagy kidolgozott épületek, nem nyiltvilágú, nincsenek környezeti elemek stb, de akkor is az a játék kib*szott jól néz ki. ÉS akkor egy 5 éves kártyán fut 150 FPS-el.

Senki nem akar optimalizálni az ég világon semmit ez a baj. Kinek éri meg? Ezért megy tönkre a mosógéped 5 év alatt, ezért megy szét egy farmernadrág fél év alatt és had ne soroljam tovább. És a mellett hogy minden kevesebb ideig bírja, vagy egyszerűen csak hitványúl van megcsinálva, egyre drágább is minden. Még a játék iparban tudtam bízni is hinni, mostmár abban sem.

Az amd elég sok felhasználót meg károsított egy amd driverrel, ami után a 6900XT ék elkezdtek meghalni. Szerencsére az enyém is meghalt azóta. Persze amikor rá jöttek mit csináltak, törölték a hivatalos drivert, majd ki adtak egy újat. Azóta meg elég sok 6900XT a temetőben van. 14 hónapért fizettem 356 ezer forintot. Igazad van jó ár-értékű kártyákat gyárt....

Azt viszont aláírom, hogy a legtöbb felhasználó nem venné észre a különbséget, de ez legfőképpen azért is van így, mert nem is érdekli őket.

Nekem feltűnő, sőt zavaró. Saját tapasztalataim alapján az FSR szimplán túl "buta" ha erősen geometrikus környezetben használják. Természetes környezetben viszont nagyon jól működik.

Ez azért nagyon nem igaz. A DLSS és az XeSS (XMX) szinte ugyanolyan jól néz ki, mint a natív, sőt néha jobban is, az FSR ezzel szemben botrányosan ronda a legtöbb játékban.

nem az AMD ellen szólok, a PS5 is arról megy es a laptopom is AMD, de azert gondolkozzunk reálisan. Nem kell a fanatikus elvakultsággal szemlélni a világot. Még mindig az asztali PC eladásokban torony magasan az NVIDIA vezet. Gondolom mindneki buta azért veszi. Ha nagyon bele akarunk kötni, akkor ott a VRAM, abban tényleg gáz, amit az NVIDIA csinál.

És hagyjuk már ezt a "én is ebben meg abban dolgozok" süket dumát, akkor szólj is hozzá úgy, ne egy olyan tényt közölj amit mindenki tud.

Az hogy most már meg is jelenik és egyre több játék fogja támogatni meg már csak hab a tortán, engem nem érdekelt soha a működése semminek, működni működik engem más nem érdekel :D a Forspoken-t Fluid Motion Frames-el játszottam végig az elejétől kezdve, remekül tette a dolgát és nagyon szuperül működött! [Igen tudom azt implementálták a játékban...,de erre egyre több példa lesz a jövőben is ;)]

Én annak örülök a legjobban hogy brutálisan kitolják ezekkel a fícsörökkel a VGA-k élettartamát [ami valjuk be már elégé a béka segge alatt volt eddig...] ha meg nem is az élettartamot tolják ki akkor hozzáadnak a látványhoz mert durvább látványvilágú/grafikájú játékokat hozhatnak össze

Ami ezen fícsörök nélkül futna 30fps-el, de ezekkel meg vagy dupláznak vagy tripláznak az FPS-en. Szóval én ennek csak örülök, az hogy hogy működik meghagyom a fejlesztőknek/tervezőknek, azok jobban értenek úgyis hozzá mint bárki más, azért csinálják ők... nem pedig mi. 😅🫡

Vannak persze játékok, amikben jól működik, de szerintem sokkal körülményesebb használni, mint egy rendesen implementál, game-specific frame gen-t, pedig utóbbinak is megvannak a hátulütői.

Enélkül viszont a generált képkockák egyszerűen nem lesznek eléggé pontosak, s éppen ezért kapcsolja ki automatikusan, gyors kameramozgás közben, mert az már feltűnően csúnya képkockákat eredményezne, ami legfeljebb nagyon magas base frame rate mellett nem lenne túlságosan feltűnő. (Aki viszont FPS hajhász, az alapból nem foglalkozik az egész frame gen dologgal, mert csak növeli a latency-t.)

Tehát a jelenség magának a technológiának az alapelvéből adódik. Kétlem, hogy ezzel bármit is tudnának kezdeni. Legalábbis nekem, mint ebben a témában laikusnak, ez jött le.

Ezt így nem mondanám, már csak azért sem, mert olyan technológiákat fejlesztenek, amik előremutatóak. Az nvidiának az üzletpolitikája vált katasztrofálissá, kihasználva a fanboyságot, a teljesítményelőnyt (jöjjön az bárhol és bárhogyan is) és a fejlesztői támogatást. Ezért is tudott belépni az intel a piacra. Nagyon bízom benne, hogy maradnak is (egyelőre úgy tűnik), mert amit ők csinálnak az is piszok jó. Nem írom le az AMD -t, volt is, van is és lesz is AMD VGA -m, de amíg az általam érdekelt technológiákat a konkurensek gyorsabban vagy jobb minőségben hozzák, addig nem fogom őket előnyben részesíteni a fő vasamban.