Az Nvidia új referencia hűtője már önmagában 150 dollárba kerül

Korábban felbukkantak az első RTX 3080-at ábrázoló képek, melyeken látható, hogy a dizájn átesett néhány érdekes változtatáson. A kiszivárgott képek alapján egy Reddit felhasználó, JDSP készített néhány 3D rendert is a kártyáról, így egy sokkal tisztább képet kaphattok a kinézetéről.

A két hűtő különböző oldalakra való elhelyezése mondható a legérdekesebb változtatásnak, és a legújabb értesülések szerint ezek elég vaskos áron készülnek el. Az Igor's Lab több érdekességet is megosztott a közelgő kártyákkal kapcsolatban, köztük azt, hogy az Nvidia új referencia hűtője önmagában 150 dollárba kerül. Az új hűtőszerkezet több egybekapcsolt hűtőborda elemből tevődik össze, a PCB pedig középen helyezkedik el. Az Igor's Lab értesülése alapján a kártya várhatóan 21,9 cm hosszú lesz. Mivel egy ilyen drága komponensről van szó, csak a három felsőkategóriás SKU-ra kerülnek rá, vagyis a TITAN RTX, RTX 2080 Ti és az RTX 2080/SUPER utódjaira.

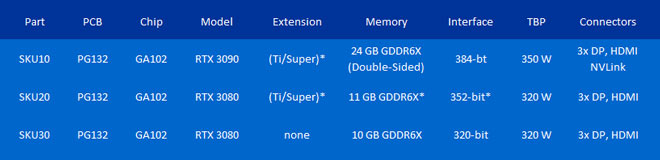

Egyelőre semmi sem biztos, de az Nvidia egyáltalán nem örült a szivárgásnak, ezért nyomozást indított a két Founders Edition, azaz referencia dizájnért felelős szállítóinál (Foxconn és BYD), amelyből arra lehet következtetni, hogy valós adatokról van szó. A dizájn mellett pedig néhány alapadatra is fény derült, amelyek a következők:

Látható, hogy mindhárom kártyára várhatóan GDDR6X memória és GA102 lesz jellemző, illetve úgy tűnik, az Nvidia eldobja a TITAN nevet, és a kártya utóda RTX 3090 néven érkezik majd.

Be vannak zárva a sulik, és tanév vége lesz, szóval egyre nehezebb ezeket beszerezni. 😞

Nekem az RX 5700-as vga-m eszik ~150W körül játék közben, mindezt egy 8 + 6 pines plusz csatlakozó páros mellett, pedig PCI-E 4.0-ás a kártya (alaplap ugyan nem).

A 300W-os limit (4. gennél 375W, ha jól olvastam) az arra vonatkozik, hogy a PCI-E csatlakozó (75W) + extra csatlakozók (300W) -> MAX 375W-ot engednek.

Jöhetnének már, marha várós 😢

Spoiler!

van még pár hasonló jó ötletem, csak szerintem a kutyát nem érdekli 😃

Engem érdekel, csak meg is tudjam valósítani 😆

Gyengek ezek nem lesznek, az viszont tuti. 😜