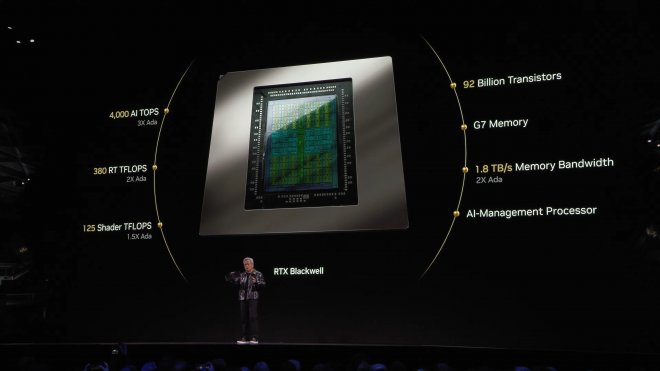

Az Nvidia bejelentette az RTX 50 „Blackwell” GPU-kat

A hónapokig tartó szivárgások és pletykák után az Nvidia végre hivatalosan is bejelentette a GeForce RTX 50 szériás grafikus kártyákat, amelyek a Blackwell architektúrára épülnek, illetve új generációs Tensor és RT magokkal érkeznek. Természetesen a DLSS 4 is bemutatkozott.

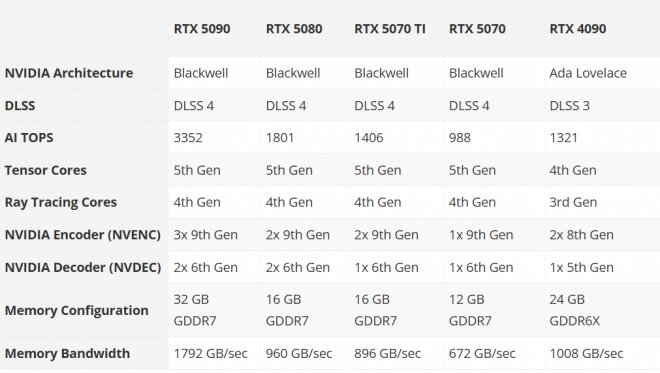

A pletykákból arra lehetett következtetni, hogy az RTX 5080-at fogják először piacra dobni, azonban az Nvidia négy új SKU-t is bejelentett: RTX 5090, RTX 5080, RTX 5070 Ti és RTX 5070. Az RTX 4090-hez képest az RTX 5090 több mint kétszer akkora MI TOPS teljesítményt kínál, de az alatta elhelyezkedő kártyák esetében is jelentős ugrásra számíthatunk.

Ez olyan funkciókat tesz lehetővé, mint a DLSS 4, amely a Frame Generationt Multi Frame Generationre emeli, ezzel még magasabb képkockasebesség érhető el, teljes ray tracing mellett is.

Az RTX 5090 és az RTX 5080 grafikus kártyák január 30-tól lesznek kaphatók, miközben az RTX 5070 Ti és az RTX 5070 februárban válik majd elérhetővé.

nem kell szarul megcsinálni a csatlakozót és nem lesz megégve.

a három csatlakozó egyébként sem praktikus esztétikailag.

Amugy az en tapomhoz adtak rendes kabelt amibol ketto megy a tapba es 1 a vgaba, szoval ugyan ugy illetve jobban is nez ki mint a regi valtozat.

Csak itt lesz egy apró baj hogy a jövő játékait még úgy se fogják optimalizálni mint eddig.

Úgy vannak vele majd a DLSS és a Framegen javítja a teljesítményt! :D

A RTX 4000 és 5000 között 20-30% natív teljesítmény különbség lehet átlagba raszterbe. A 30%-ot is a legjobb jó indulattal írtam.🤔 Szóval ami megint eladja a kártyát az a DLSS teljesítménye.

a teljesítményt majd csak akkor lehet tudni ha kijöttek a kártyák mert amit az nvidia élő bemutatóban mutattak az lehet átverés is na meg az is számít hogy mennyit fog valójában fogyasztani.

Minden esetbe érdemes várni, de 2025-ba egy 8 gigás új generációs kártya nem a legjobb befektetés.

Ez az emberek àtbaszasa.. olyan Ghost van az extra 3 frame nek... Hogy nagyon gàz.... 😂

6060 talán már nem 8GB lesz xD

de ha 6070 16GB azt sem bánom

messze van még az kb 2 év addig bármi lehet

Egy friss Black Ops 6 benchmark a sima 9070 re (nem XT re) is majdnem 4090 nyi FPS számot adott ki natív FSR nélküli 4K n Extreme szinten is! 99fps t hozott!

Gamingre abszolút felesleges váltani 4XXX szériáról, kivéve ha majd az 5060/ és 5060ti jön ki mert akkor azért az a +2-3 frame amit a MFG generál majd az nagyon jól fog jönni mindenkinek ha még most nem is de a későbbiekben időtállóbb lehet. (Szerintem)

4070//4080//4090 ről én nem váltanék... 4090ről is csak akkor ha munkára használnám, de akkor sem rohannék a boltba az 5090-ért,hanem kivárnék.

1. Nincs konkurencia ami indokolná a fenyegetettséget ebben a szegmensben

2. Az 5090-re 32gb GDDR7-et pakoltak (ez 33%-kal több mint az előző gen csúcsa a 4090-nél)

3. lesznek Ti verziók biztosan, csak szerintem nem az 5090-nél.

4. Azért kapott pl az 5080 is ,,csak" 16gb -ot mert abból biztosan lesz nagyobb vrammal megáldott verzió is Ti vagy super néven.

De még1x ezek meg az én nézeteim, igazából az hogy vannak letiltott cuda magok, nem jelenti azt hogy lesz is folytatás mert az 5090 valjuk be 32gb vrammal,gyorsabb memóriával és az új MFG-el szerintem jóval többet ad már így is mint azvelőző gen csúcsa. Aztán majd visszatérünk rá egy fél év múlva hogy kinek lett igaza 😅🤝

5070Ti viszont meglepően jó vétel is lehet ezen az MSRP-n, aztán majd az eu kisker árak lesznek a döntőek úgy is, de egyelőre biztató. Ampere és RDNA 2 tulajoknak akik nem akarnak komplett vagyonokat elkölteni jó alternatíva lehet az újításhoz.

Bár az egész CES show legérdekesebb újdonsága NV oldalróla Reflex 2 volt, de az meg az egész RTX családon belül működni fog, nem 50 series specifikus dolog.

Maguk a káryták szerintem mehh... volt már ennél jobb gen. váltás is...mondjuk rosszabb is. Ez a DLSS4 meg extra-mega-brutal-hyper frame generation ami 27 frameből csinál 243-at a promó kép alapján... egészségedre Jensen. Ha ebben az ütemben haladunk talán majd a DLSS 8 környékén lesz olyan minőségű a kép mint egy mezei TAA. Ku*va jók ezek a promós képek, hogy még élesebb is mint a natív állóhelyzetben, statikus screenshoton...csak játék közben szerintem az emberek mozognak.

"4090 performance on $549".... az hogyne... csodálom, hogy végig bírta mondani röhögés nélkül. De hányan beveszik majd ezt is mint mindig.

Majd az AI megoldja ezt is mint mindent. Adok 400 kamu dollárt a kamu frameket generáló 5080ért, a maradék 1100-at meg legenerálja az AI a NV-nek. Deal?

Spoiler!

DLSS 5: You watch AI play the game. Buttery smooth experience, zero latency

DLSS 6: AI plays you

DLSS 7: You are the AI

Az upscaling-et én speciel nem bánom, DLSS Quality sokszor még 1440p-n is jobban néz ki, mint az okádék TAA implementációk, natív felbontás ide vagy oda.

Frame Gen viszont kb. mint halottnak a csók, szerintem is egy iszonyat nagy gimmick az egész.

A framegen meg nettó bullshit, a sok FPS-ben az volt a lényeg, hogy sokkal folyamatosabb a kép, és ebből kifolyólag az irányítás is, ez a marketingszemét csak az egyiket tudja, a másikon még ront is.

Quality módban. FSR3 használtam Stalker 2-be. 3080Ti nincs még ez a nagy kamu frame. Csak FSR3 al 🫡

De azért kicsit többre vártam AI nagyon ott van most az új kártyáknál!

Ez az Nvidia és AMD olyan mint ha jobban lennének söt még talán rokonok is!

természetesen a tesztekre vagyok kiváncsi !

[LINK]

RTX 5080 256bittel 960/ ram sebessége.

RTX 4090 384bittel 1008/ lassabb ram Dr nagyobb sàvszélel.

CUDA magok is több van a 5080 ön és újabb magok. Nagyobb órajal. Szerintem 15% tuti ver rà Nativban.

Nem véletlen, hogy az RTX 5090 és 5080 között hagyott egy szakadékot az nvidia, ott marad az RTX 4090.

Nyilván ha nem az NV, akkor majd más lovagolta volna meg a trendet, de miért adnák át másnak a terepet ha minden eszközük adott, hogy éllovasok legyenek? Hülyék lennének, jól tették.

Viszont azt is látni kell, hogy ez megint csak egy trend, ami idővel apad. Nem fog akkorát és olyan gyorsan esni mint a crypto mining mert azzal ellentétben ennek még értelme is van, de szépen lassan és csendben beépül a legtöbb iparágba, nem lesz a piac rászorulva arra az 1-2 disznófejű mágnás cégre mert a sarki coopban is lesz USB-C csatis AI core generátor admirális generális amit két utcával feljebb a helyi Kft. rakott össze. Ugyanúgy mint ahogy 2008-ban aki smart phone-t akart csak egyet tudott választani az iPhone-t, ami mai szemmel jó drágán jó szar, most meg bemész a Yettelhez és 25-ért hozzádvagják ami ugyanúgy megfelel a smart phone kategória besoroláshoz szükséges összes tulajdonságnak.

Visszatérve a dGPU-khoz konkrétan, azért éppenséggel lenne még hova csökkenteni a node-ot, meg létezik más design is a monolitikuson kívűl. Persze ez nem mind az NV hibája, hanem úgy általánosságban az iparág összes résztvevője tehet róla. Egyértelműen könnyebb beállni egy trend mögé, ami azon túl, hogy az általuk forgalmazott termék használati értékét eredendően képes javítani, de még megbocsájtó is lesz a publikum mert amúgyis áll a szerszám az aktuál trendre. Ezt pedig mégtovább tudja tussolni a marketing és a média, hogy amúgy érdemi munka konkrétan és úgy nem mellesleg egyébként nem is igazán folyik.

Ezt kifejthetnéd bővebben.

Nyilván ha nem az NV, akkor majd más lovagolta volna meg a trendet, de miért adnák át másnak a terepet ha minden eszközük adott, hogy éllovasok legyenek? Hülyék lennének, jól tették.

Ezt nem tudom aláírni. Az nvidia a cég felvirágzása és a CUDA platform kiépítése óta nagyon erősen épít a kutatásra és fejlesztésre, nem a hype train -re ülnek fel, hanem ők fektetik a síneket. A trendalkotásnak csak az egyik oldala a piaci haszon, a másik viszont a technológiai fejlődés. Amit az nvidia most csinál, az nagyon erős befolyással rendelkezik a jövőre, ezért is kerültek oda, ahol most vannak. Egyértelmű, hogy ha nem ők kezdték volna, akkor valaki más lenne a helyükön, de nekik voltak erőforrásaik, tapasztalataik és elképzeléseik, amiket megvalósítottak.

Ez a technológiai szektorban mindig így működött és ha nem történik valami hatalmas katasztrófa, akkor így is marad. A drága újdonságok idővel olcsóbbá és elérhetőbbé válnak, így a használatuk is általánossá válik. De nem értem, hogy ez mit változtat az itt diskurált témában. Pontosabban ez a technológia használhatóságát és értékességét mutatja, nem pedig annak ellentétét.

Megfelel a kategória besoroláshoz szükséges tulajdonságoknak, de ezt leszámítva kutyát dobálni való. Az olcsó smartphone -ok se nem jók, se nem tartósak, se nem biztonságosak. De itt már nagyon eltérünk a témától.

A node méretének csökkentése nem olyan egyszerű, mint korábban. Sosem kellett még annyira node specifikusan tervezni az architektúrákat, mint az elmúlt években. Chiplet design -nal sem vagy előrébb, mint a monolitikus chipekkel, sem fogyasztáscsökkentésben, sem teljesítménytöbbletben. Az egyetlen előny a yield. Ha sűríted a tranzisztotokat, akkor csökkentened kell az órajelet, mert megfő a chip. A 3D chiplet design számolók esetén nem haszálható jelenleg, illetve hőtermelés szempontjából sem praktikus. Szimplán nem áll készen még olyan technológia, amivel a jelenlegi problémákat relatíve gyorsan meg lehetne oldani. Nem minden csak trend és marketing.

Elég kemény érdemi munka folyik a háttérben az iparág több résztvevője részéről, csak éppen ennek nincsen hírértéke, mert még nincsenek olyan eredmények, ami a felhaszálói oldalon kézzel fogható lenne.

Ha pusztán matematikai alapon nézed a hagyományos raszteres grafikát, akkor nagyon gyorsan belátható, hogy ha ezen a vonalon akarunk gyors ütemben tovább fejlődni, akkor egy - két éven belül tényleg reaktorok lesznek a számítógépekből. A ray tracing és az AI a legpraktikusabb megoldás feloldani rengeteg korlátot és még gyorsabban emelni a színvonalat, mint azt pár éve csak reméltük volna.

Ha ezt nem akarjuk, akkor megállhatunk a jelenlegi teljesítményszinten, amiből a játékfejlesztői oldalon még ki lehet préselni talán 20 - 30% -ot célzott optimalizációval és a művészek / designerek megfelelő munkájával, de ennyi.

Egyébként a mai grafikai szint szerintem már elérte a non plus ultra szintet. Még látszik, hogy nem valódi, de már nagyon közel áll hozzá. A legtöbb már tényleg csak a művészeken múlik, nem a technológián.