Az AMD leleplezte a Radeon RX 6800 XT és RX 6900 XT kártyákat

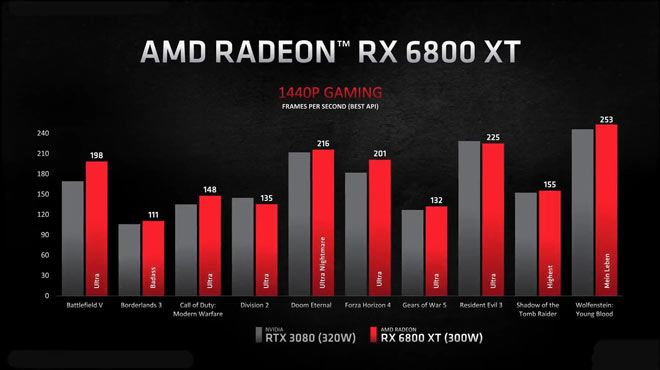

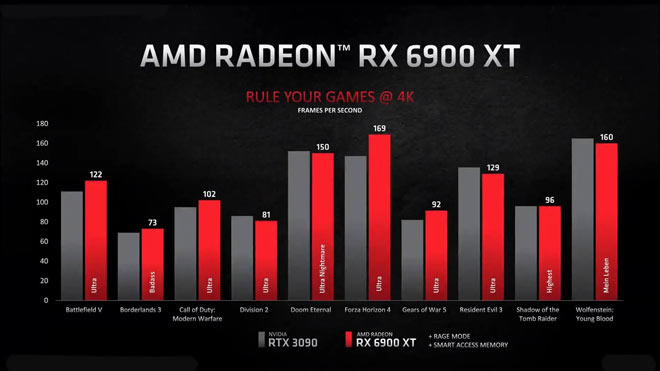

Az AMD hivatalosan is leleplezte a felsőkategóriás RDNA 2 GPU-it, azaz az RX 6800 XT-t és az RX 6900 XT-t. Ezek az Nvidia GeForce RTX 3080 és RTX 3090 kártyáival veszik majd fel a versenyt, és a teljesítmény demonstrálása céljából a cég közzétette az első first-party benchmarkokat is.

Az AMD Radeon RX 6800 XT-re 72 számítási egység, 2015 MHz órajel, 2250 MHz boost, 128 MB Infinity Cache, 16 GB GDDR6 VRAM és 300W TDP lesz jellemző. A GPU kiinduló ára 649 dollár lesz, és november 18-án érkezik az RX 6800-zal egyetemben. A Radeon RX 6800-ra - amely jóval erősebb, mint az RTX 2080 Ti - 60 számítási egység, 1815 MHz órajel, 2105 MHz boost, 128 MB Infinity Cache, 16 GB GDDR6 VRAM és 250W TDP lesz jellemző, a kiinduló ára pedig 579 dollár lesz.

Az AMD ezenkívül egy másik modellről is lerántotta a leplet. Az RX 6900 XT lesz a legerősebb RDNA 2 kártya, amely december 8-ától lesz kapható, és mindössze 999 dollárt kérnek érte. Ez a GPU az RTX 3090-nel veszi majd fel a versenyt, miközben jóval alacsonyabb áron kínálják. Az RX 6900 XT alapadatai a következők: 80 számítási egység, 2015 MHz órajel, 2250 MHz boost, 128 MB Infinity Cache, 16 GB GDDR6 VRAM és 300W TDP.

Az AMD mindkét RDNA 2 GPU-ja DirectX 12 Ultimate és DirectX Storage támogatással érkezik.

Ezt csak úgy itt hagyom! 😂

Aztán teljen el pár hónap, amíg szépen beilleszkedni a kártya a pc világba.

Utána már lehet stabil alapokon nyugvó döntéseket hozni.

Amd nél meg a 3xxx széria kérdés hogy ugyan úgy ki tudja majd hajtani a 6000-es rx-eket...valószínűleg nem....így az megint teljesítmény vesztés... tehát majd ha a tesztek kint lesznek majd kiderül minden.

Szerk.: Utóbbi csak Win-re érvényes, Linuxon működik 😆

Tehát -10%, ha bizakodóak vagyunk AMD oldalon, még akkor is.

Ahhoz képest merész lépés volt a 6800XT-t ilyen közel árazni a 3080-hoz, hogy RT-ben veszt, és valószínűleg 5-7%-kal alatta is fog maradni - és akkor ez még Ryzen 5000 széria mellett. Egyéb esetben meg lehet, hogy 15-20%-kal is.

A 16GB ram kielégíti azoknak a felhasználóknak az igényét is,akiknek valamiért kevés lenne a 8,10GB memória. 😀

Az AMD meg keresett annyit a közép mezőnnyel is, hogy jól el legyen vele. Persze az egy pozitívum, hogy már a felső szinten is tudják ütni egymást.

Meg ugye az NV sem gurít sok mindent ebben a szegmensben. A 3070 is ritka kincs lesz az első hónapokban

Tehát ha valaki akar venni egy ütős kártyát, amit használhat 4k-ban is, az nem fog több fps-t kapni, ha ő fhd-ban akarja használni.

Amiről nem tudni(?), hogy ha kijönnek az olcsóbb/gyengébb kártyák, akkor azok milyen felbontáson milyen teljesítményt fognak hozni? Mert akkor elvileg fhd-ban azok lényegében ugyan ott lesznek, mint az előző generációk.

Spoiler!

a 10750H gyorsabb a 4900H-nál 😂

Egyik sem jobb a másiknál..

Aztán ha mégis kiderül, hogy az AMD sugárköverése egy használható dolog, akkor meglátjuk, ohgy a régi játékok is adoptálják-e majd vagy csak az újabb címeknél lesz elérhető. Engem pl a Cyberpunk érdekel leginkább, ohgy ott mi lesz. Elvileg a konzolokban is van Navi alapú raytracing tehát ez alapján számoltak a fejlesztők az AMD vel.

Kíváncsi leszek a konkrét ray tracing tesztekre, ott még elvérezhet az új architektúra, bár kétlem, hogy ez történne.

Ha minden klappol, akkor 2020 lesz az év, amikor az AMD teljesen visszatért.

Viccet félretéve nagyon örülök, hogy valami csoda folytán VGA fronton is feltudják venni a versenyt. Ez a 2020 legalább AMD-nek jól sikerült. 😀 Erősen megvan szorongatva az NV a 6ezresekkel és verve van az Intel a Zen 3-al. Mikor volt ilyen utoljára? Procinál mindkét fronton nem tudom, jó rég... VGA-nál meg szerintem utoljára igazán sikeres széria a HD7000 volt, azóta ezt érzem a legjobbnak. Történelmi pillanatok... 😀 A következő csata pedig... szintén nagyon durva lesz. Nagyon nagyon kíváncsi leszek 2022-re. VGR fronton valszeg RDNA 3 és a Hopper mérkőzik meg, lehet mindkettő többchipletes dizájnnal. Az NV biztos készülni fog, mert látja mi a helyzet és a reakció, az AMD pedig megszeretné majd tartani amit végre megszerzett, gondolom én, úgyhogy nagy csaták lesznek. 2022-re az Intel is összekaphatja magát valamennyire, a Zen 4 pedig új foglalattal, PCI-al, ramokkal, 5nm stb... valószínűleg ütni fog. De biztosan az Intel is készül arra már valamivel, szóval ott is izgalmas harcok lesznek.

Érdekes éveknek nézünk elébe, alig várom. (: Tiszta retro.

hát igazából semmit sem szerzett még meg, mivel egyelőre annyit értek el mindösszesen, hogy versenyképesek minden szegmensben. Viszont mivel az árak nem elég alacsonyak, a picai részesedésük továbbra is elhanyagolható az Nvidia egyeduralom mellett. A felhasználók 74%-a a steam felmérésben Nvidiát GPU-t használ az AMD 16%-ával szemben. Viszont mostmár egyrészt van alternatíva, másrészt mivel az Nvidia kártyák nem kaphatóak, mindössze annyit kell tenniük hogy a karácsonyi vásárlási láz teljes volumenével őket segítse, hogy az ő kártyáik kaphatóak legyenek.

Nagyon sok múlik most az Amerikai eseményeken.. 😳

Valami 187ezerért árulták a procit kezdő árral. Érdekes volt, mert kétszer drágábban adták.

Beszerzési ár + 27% áfa + 1.3-as cumiszorzó...

Ilyen az élet 😃

No meg lehessen kapni!

Az utolso par perc tetszett a legjobban, kivancsi vagyok arra a 6900 XT-re. 😃

Engem megleptek rendesen.😃😆

RX 580 al sem... de még a full HD- is neccessen ment... GTX 1060 6Gb al meg megy a 1440p Strem is 😃

AMD hez több internet kell elvileg.. de nem tudom ez hogy lehet?! Nvidia hogy stremelhez akkor kisebb nettel is ?

Ilyen gondrol se hallottam meg mondjuk.😆