Az AMD hivatalosan is leleplezte a Radeon RX 7900 XTX és 7900 XT kártyákat

Az AMD végre hivatalosan is leleplezte az első Radeon RX 7000-es asztali grafikus kártyáit. A harmadik generációs RDNA architektúra idén decemberben a high-end RX 7900-as széria két példányával fog debütálni.

A vállalat a Radeon RX 7900 XTX és RX 7900 XT kártyákról rántotta le a leplet. Előbbi alapja a teljes Navi 31 GPU (12288 Stream Processors), míg az utóbbié egy cut-down GPU, 10752 maggal. Az AMD megerősítette, hogy a Navi 31 GPU 58 milliárd tranzisztorral rendelkezik, és 61 TFLOP teljesítményre képes. Az 5 nm-es node-nak köszönhetően a GPU-t 165%-kal nagyobb tranzisztor sűrűség jellemzi a Navi 2X-hez képest.

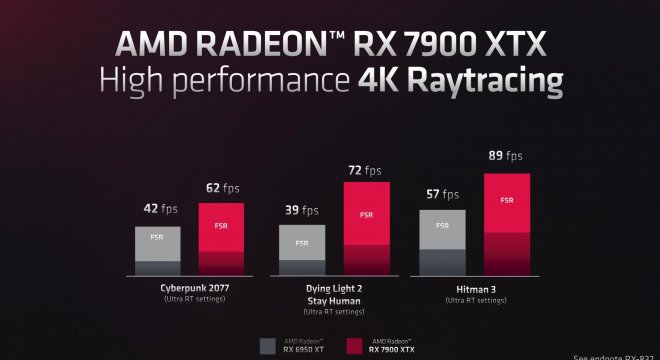

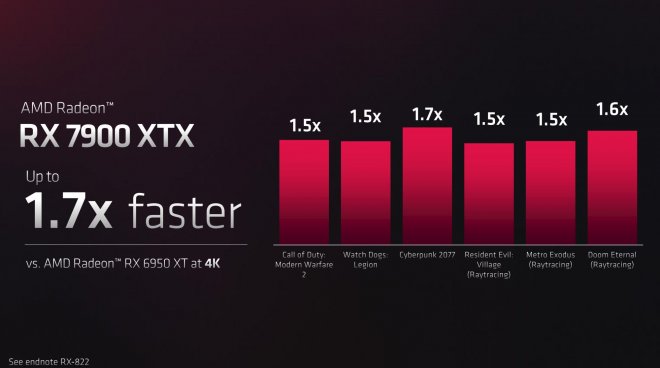

Sajnos azt nem mutatták meg, hogy a kártyák mire is képesek az RTX 4000-hez képest, azt viszont igen, hogy mekkora teljesítménybeli különbségről van szó a leggyorsabb RDNA2 GPU-hoz viszonyítva. Az RX 7900 XTX lesz az első olyan Radeon kártya, amely támogatja a DisplayPort 2.1-et, 8K 165 Hz és 4K 480 Hz támogatást biztosítva.

Mindkét modell december 13-án válik majd elérhetővé, és a rivális termékeihez képest jóval olcsóbban kerülnek majd a boltok polcaira. A Radeon RX 7900 XTX 999 dollárért, míg az RX 7900 XT 899 dollárért lesz majd beszerezhető.

Akik 4090 be fektettek jól beszopták

Ezt majd az ár/érték arány diktálja.

Bár ezzel az árazással az XT nekem feleslegesnek tűnik, ezer dollár felett nem +/- 100 fogja eldönteni már, hogy melyik legyen, sokkal több fog fogyni az XTX-ből és nem is véletlen.

Itt mindenki döntse el magának, hogy fontos e neki a DLSS 3, vagy esetleg RT-ben többet akar mint 60 FPS. Én ahogy olvasgatok mindenféle belföldi, külföldi fórumokat a 6900 XT-t a legtöbben 2k-ra vettek az emberek, nem lesz szerintem másképp itt sem. A 4090 különbözetéből egy nagyon fain 1440p 144hz 1ms FreeSync monitort lehet már venni, ezek már tényleg preferencia beli kérdések.

Valahol már ijesztőek ezek a teljesítmények, nem igazán vagyok biztos benne, hogy 2k-ban nem bottleneckeli bármilyen CPU ezeket, FullHD totál felejtős most már végleg, magasabb felbontáson lehet több FPS-t kap az ember olyan mértékű szűk keresztmetszetről beszélünk.

Ugye azt tudni kell hogy akkor beszélünk fejlődésről a hardvereknél ha ugyan azon a méreten/áramfelvétel mellett érnek el nagyobb teljesítményt (ezt egy magyar játékfejlesztő mondta,és valjuk be van benne valami…)

nVidia kicsit elhagyta magát úgyérzem, persze jobb,erősebb a pirosaktól, de mi áron?!

Azt mondtam nem cserélek vga-t , de ha egy 7800 jó áron lesz kapható és jó áron elmegy a szeretett 6800 am akkor még meg is gondolnám a váltást.(bár semmi nem indokolja hogy cseréljem a 6800-at,mert játékra elég brutál ez is!) Majd kiderül, ebből úgyis csak 2023 lesz. Addig pedig sok víz lefolyik a dunán :D

Jaaa ami viszont tetszett a pirosaknál hogy az FSR 3.0 megint lesz mindenre is! És hasonlóan fog működni mint a dlss 3.0, akkor kérdem én miért nem tudta ezt a zöld oldal megvalósítani? Ez sok mindent elmond a 2 gyártóról! Azt írtam hogy nem dobtam el az agyam a bemutatótól,de azt megkell hagyni hogy az AMD jobban a gamerekért van mint az nVidia…és szó nincs arról hogy fan vagok… mert nem vagyok, csak nézzük a tényeket kérem…

Ha érted a különbséget a DLSS és a FSR között, akkor nem teszed fel ezt a kérdést. A két eljárás alapjaiban különbözik egymástól, a DLSS sokkal jobb minőséget hoz, de hardveres támogatás kell hozzá. Nem sokat érne, ha lenne egy szoftveres verzió, ami mindenen fut de lassú mint a dög.

Ezt nem csak egy magyar fejlesztő mondta, hanem ez az alapvető elvárás. Amibe csak az szól közbe, hogy egy nagyon komoly technológiai határ szélén állunk, így a teljesítmény / watt arányt már nem lehet olyan egyszerűen csökkenteni. Nem véletlen az AMD MCM megoldása.

Míg AMD megoldása tovűbbra is megy kenyérpirítón is addig Mészáros lölő meg veheti a 4090-et 1500 dodó-ért (ami jegyzem meg a viszonteladóknál már kb 2.3/2.5 ezer dollár körül van már :D) ha DLSS 3.0-t akar kapcsolni ez itt a rohadt nagy különbség!

ez lehet így volt az első verzióknál (FSR 1.0) de én mostanság nemigen látok különbséget...

bár lehet az én szememmel van baj de ha te látsz valami különbséget,gyors ránéztem pár videóra hogy nehogy hülyeséget beszéljek itt.. ,de komolyan érdekel az a ,,Sokkal jobb minőség" amit említettél, mert én semmit nem látok, max ilyen 200X-os zoom mellett a 200km-re lévő híd felett repülő fecske jobban körvonalazódik DLSS-el mint FSR 2.1-el vagy 2.0-ával, értem én és aláírom hogy az eljárás jobb a zöld oldalon de azért hogy ,,Sokkal jobb" ez brutál erős túlzás már elnézést...és nem védeni akarom az AMD-t azért mert nekem ez van hisz elmondom énis hogy jobb a DLSS csak az a túlzás hogy ,,sokkal" ez erős :D én inkább úgy fogalmaznék hogy egy hajszállal

xCube-nak maximálisan igaza van a technológiai határt illetően, ezért is léteznek és ezért is relevánsak ezek az upscaling megoldások, de az NV szinte mindent ennek rendelt alá. Az előző generációs zászlóshajó alatt a felsőkategóriában 8-10 GB kártyák sorakoznak amelyek már a közeljövőben is képtelenek lesznek ellátni bizonyos feladatokat és hiába maga a GPU bírná a terhelést ez a memória mennyiség limitációt fog okozni, vagyis okozna, ha nem lenne a DLSS, de már sokszor kifejtettem ezzel a kapcsolatban a véleményemet és még ki is fogom, NINCS mindenben DLSS, főleg kisebb stúdiók játékaiban, ott meg kalap kabát már akár pár hónapon belül is az ilyen 3070 és társainak. Nem viccelek, az új cod 1080p-n betermeli az 1070-em mind a 8 gigáját, akkor egy alapvetően 2k-ra tervezett 3070-el mi a helyzet ténylegesen olyan felbontáson használva? Már most gatya neki.

Én kiállok amellett, hogy jók ezek az upscaling megoldások de én látom köztük a különbséget a natívval összevetve és sokkal rosszabb FHD / QHD-n, 4k-ban oké, ott tényleg talán még jobb is de az a kisebbség akinek olyan megjelenítője van. Ezeket arra találták ki, hogy gyengébb géppel is átvészelhető legyen a crypto piac 2-3 éves ámokfutása és aki leragadt a Pascal / Turing érában azok is tudjanak kezdeni magukkal valamit... vagy arra, hogy tényleges munka nélkül ugyanazt a 40 éves gyártási metódust évről évre foltozgatva se tűnjön fel senkinek, hogy amúgy szar van a palacsintában. Döntse mindenki el magának.

Mégegyszer kihangsúlyozom, hogy az én meglátásom szerint ezek arra lettek kitalálva, hogy a gyengébb kártyával rendelkező konfigok is érjenek valamit, az ilyen több százezer, millió forintos kártyák esetében önmagában szégyen, hogy ezek marketingjében egyáltalán említésre kerül ezeknek a neve is nem hogy erre építenek ki komplett termékcsaládokat. Ez olyan mintha egy mesterséf a saját éttermében ahol 200 eur csak az, hogy leteheted a segged a székre azzal dicsekedne, hogy milyen finomat főzött neked egy kis glutamát hozzáadásával mikor az arra lett kitalálva, hogy az olcsó ételeknek is legyen valami íze és ne köpd ki egyből.