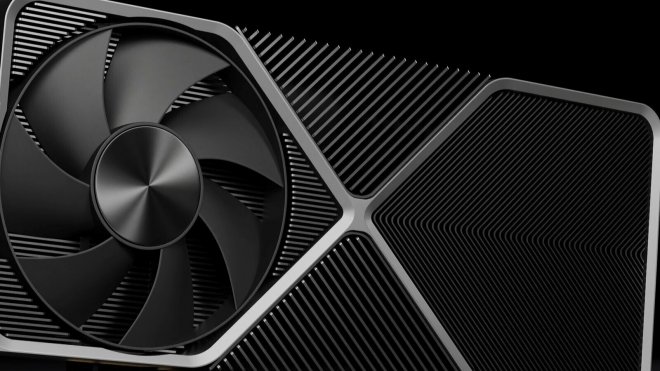

Akár 70%-kal gyorsabb lehet az RTX 5090 az RTX 4090-nél

Bár az első megjelenéssel kapcsolatos részletek alapján az Nvidia 2025-ig fog várni az RTX 5090 kiadásával, az első pletykák máris felröppentek a cég következő generációs kártyáit illetően, köztük azzal, hogy az említett high-end modell akár 70%-kal is gyorsabb lehet az RTX 4090-nél.

A pletykákról először Panzerlied számolt be, vagyis ugyanaz a leaker, aki korábban az Nvidia következő generációs fogyasztói GPU-ival kapcsolatos első részletekről is lerántotta a leplet, illetve arról is, hogy az Nvidia az xxx04 osztályú GPU-k kihagyását tervezi. Ezt látván a VideoCardz egy másik népszerű szivárogtatóval is felvette a kapcsolatot, aki szintén megerősítette az információkat.

A közzétett adatok szerint az RTX 5090-et 50%-kal nagyobb méretarány, 52%-kal nagyobb memória-sávszélesség, 78%-kal nagyobb L2 cache és 15%-kal magasabb órajel fogja jellemezni. Ez összességében pedig a korábban említett 70%-os teljesítménynövekedéshez vezet, csak kérdés, hogy a kártya fogyasztására mindez mekkora hatással lesz.

Ilyenkor már kész a proto tipus.

AMD oldalon is már készen van régen a 8950X sorozat gyártásra vár. És már a tesztpadon tesztelik a 9950X procikat.

10Ghz es rammokat. Sőt DDR6 is fejlesztésbe van már, hiába jön majd sokára. Belsős driverekkel tesztelik ezeket.

Most amilyen mobilok kint vannak, már rég őskor. Azért is tudd évente új jönni.

Ott vannak a vakcinák is pl, ezek a vírusok amiket most szabadidgatnak el, már 1970 be polcon voltak készen. Ezt egy Német Virologus Prof mesélte nekem. Vakcinakat se most dobták össze 1év alatt.. Az egy mese.

Amúgy pontosan azért tolták ki a megjelenést 1 évvel, mert újra akarják gondolni az egészet, mert rájöttek a mostani év után hogy mégse hülye mindenki. Amúgy meg nem igaz hogy több mint 2 évvel előre leakeltek valós adatokat, ilyen még sosem volt.

Főleg hogy 3.5hónapja azt állították hogy 2025ig biztos nem jön ujabb.. Persze hogy vegyék 4xxx szériát.

Bazia nem éri meg 4070Ti venni se szerintem 400+ezerbe amikor 250k körül kapsz 3080Ti vagy 3090 et is.

Igaz DLSS 3 at nem tudják. De annyival nem add többet. A gyártók meg sajnos azt csinaljak. Hogy ami már nem friss kártya, és árba lejebb kell menniük mert nem veszik már. Azokat rosszabb minőségű anyaggal potolják. "chippek"

Cserebe tudnak árat csökkenteni majd.

GDDR7 gyartasa durva drága lesz.

Most is azt állítjak hogy 2025ig nem jön ujabb, de hiszem ha látom.

Most is azt állítjak hogy 2025ig nem jön ujabb, de hiszem ha látom.

Játékra meg teljesen mindegy, ha vagy a kártya nincs konzisztensen összerakva (megfelelő Vram, sebesség, stb.) vagy a játékok olyan bődületesen összehánytak lesznek, hogy a legjobb gép is elhasal rajta még tonnányi patch és mod után is.

Arról nem is beszélve, hogy top csúcs kártyákat felskálázó technológiákkal promóznak teljesítmény tekintetében, ami pont olyan, mintha árulnak neked egy kocsit minden féle csili technikával, teljesítő képességgel, de már az elinduláshoz is nitro gombokat kell nyomogatnod.

Egy iphone-ért mennyit adnak ki az emberek?

Nem tudom te milyen felbontáson játszol, de ide haza legtöbben még fullhd felbontáson játszanak. 4K-án nem sokan tolják, ebből kifolyólag egy RTX 4090-el el lehet lenni évekig kompromisszumokkal, ha nem 4K felbontáson játszik az ember.

A mai világban mi az olcsó?? SEMMI!

Akinek drága ott van a konzol vonal.

Én tavaly millió felett raktam össze a gépemet, kicsit se zavar hogy az akkori csúcs kártyám már nem az. Vagy a procimból jött ki újabb. Annak örülök hogy fejlődik az ipar.

Én inkább gépre költöm azt a pénzt amit más telefonra költ évente. Ezért pontosan tudom hogy a telefon se olcsó buli. Van olyan ismerősöm aki 800 ezeré vett telefont, szóval hogy mi a drága abba felesleges bele menni.....

A 4090 4K kártyának készült,bár ha nem is visz mindent reccenés mentesen kimaxolva 4K-ban,az már az optimálásnak is köszönhetö.Viszont egy 4090 kaliberű kártyát 1080p-re venni megint csak fura dolog.Arra vannak gyengébb,olcsóbb karik is amik még két évig ellesznek FullHD felbontáson.Én már kevesebbet játszom,és néha retró játékokkal,viszont a 6700XT még jódarabig eléglesz nekem 1080p-ben ha sokminden nem is maxon.De mindenki arra költi a pénzét,amire szeretné.Nem célzok most senkire,de vannak akik mindég a legujabbat megveszik.A baj ezzel csak az,ha most megveszel valamit 500k-ért,6hónap mulva nemkpasz érte csak 350k.Ahogy kihozod a boltbó,máris esik az ára.

Lehetne erről naphosszat vitázni,de felesleges....van aki látja a gondokat és van aki nem.Ès itt nem csak az optimalizálásról van szó.

Még most sem támasztottad alá amit írtál. 4 hónap alatt sem sikerült.

Persze csak akkor ha végre tesznek értelmezhető mennyiségű VRAM-ot a kártyákra. 5070 minimum 20G kellene, hogy legyen, hogy egyáltalán érdekeljen, de akkor az még mindig 4-el kevesebb mint a jelenlegimen, bár az már mindegy, amíg nem jön több only next gen csutkára pakolt UE5 játék addig nem fogjuk megtudni a tényleges igényeket. Next Gen exkluziv címeknél bekapcsolt RT-vel és FHD-tól magasabb felbontáson már láttunk egy pár címet ami 12GB+....és hol van még 2025?

Az se fog javítani a felső-közép/felső kategóriás kártyák árazásán ha az AMD felőli pletykák is beigazolódnak és nem fognak high-end GPU-kat kidobni a 8000-es szériához aztán majd lehet kamillázni, hogy az 5070 16G miért indul fél miskáról a 5080 meg miért veri a 800 kilót.

Azt is tudnám értékelni, ha visszaállnának a régi számozás / erőszintre, ez az eggyel lefele tolt perf. / eggyel felfele tolt price nem igazán szimpatikus. Nem baj ha valami drága, csak akkor legyen megindokolva normálisan és ne próbáljanak meg átb*szni. Értem én, hogy 2 év alatt sikerült megszokni a scalper miner x² cash-t, csak éppen azóta kipukkadt az a lufi és elfelejtették, hogy belőlünk élnek, mint az elmúlt jó pár évtizedben és pár emberen kívűl nem sok mindenki fog $2-3k-et kiadni kártyáért még akkor sem ha az olcsóbbaknak szándékosan csak annyi a kizárólagos célja, hogy elrettentsen és a nagyobb felé tereljen mert "mennyivel jobb vétel". (Ugye-ugye 4070/70Ti?)

2024-es évet lazán kihúzza még erőben a 4090 szerintem.

Olyan árazása lesz, hogy hamarabb megveszed, akkor már kifutónak számító 4090-et.

Talán addigra eléri a kb. 350 ezer forintos árat. Kétlem hogy ez alá befog esni bármikor is. Persze ha vársz megjelenés után 1 évet, akkor lehet 600-700 körül megtudod majd venni az 5090-et. Meg ha adol is ki ennyit egy kártyára! 😁

azért 1200W már kegyetlen lenne

Itt a fogyasztása fog legkevésbé is érdekelni bárkit ha hozza a 70%-ot...

Jelenlegi Vega 64 em is röhögve megeszi a 300W ot, aztán egy 3060 szintjét sem hozza,mégsem tépem a hajam, hogy sokat fogyaszt, szimplán ez volt a legjobb kártya a pénzemért az adott időben. (ergo a fogyasztás nálam sem túl nagy szempont)

Fogyasztás nem feltétlen csak fenntartási ár miatt, de fejlődés mértéket tekintve is érdekes lehet.

Szerintem a mai tendenciát nézve várható többlet energia igény.