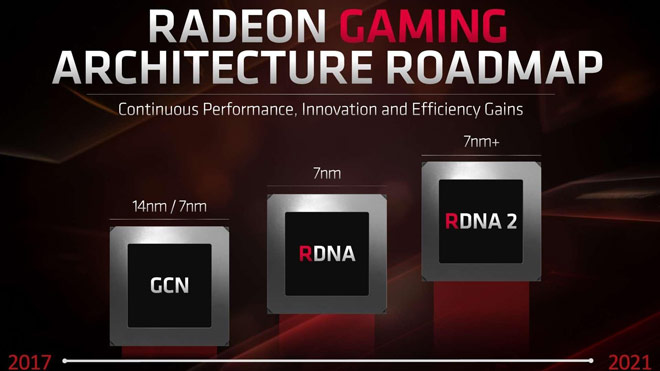

Ekkor leplezi le az AMD az új RDNA 2 GPU-kat

Az AMD a közelgő Financial Analyst Day során mesél majd többet az RDNA 2-ről, vagyis a cég következő generációs GPU architektúrájáról.

Maga a Financial Analyst Day megnevezés egy kicsit kevesebbet takar, mint ahogy az elsőre hangzik. Az eseményen valószínűleg nem kerül sor a teljes specifikáció leleplezésére, de az AMD megerősítette, hogy az utolsó negyedéves pénzügyi jelentése során további információval szolgál majd a hamarosan érkező architektúrájáról.

Az RDNA teljesen az alapoktól lett felépítve a játékosok számára. 7 nm-es gyártási folyamattal készülnek, és jelenleg az RX 5700, RX 5600 és RX 5500 szériák érhetők el. Az RDNA 2 pedig ennek az architektúrának a fejlesztett változata lesz, amely a következő generációs konzolokban is helyet kap. Az AMD szemszögéből az RDNA nem más, mint egy frissített Navi, amely mellesleg ray tracing támogatást is kapni fog.

Az említett Financial Analyst Day 2020. március 5-én esedékes 22:00 és 03:00 között, amely elérhető lesz az AMD weboldalán.

Amúgy vissza az eredeti témához, szerintem a számításaid jók, szerintem AMD-ék, most minden oldalról összeszedték magukat, emlékszem, hogy valaha csak AMD kártyám volt (vagy ATI), mert olcsón, nagyszerű teljesítményt (nVidia FX idpőszak) és szebb képminőséget adtak. Kezdődött Ati Radeon 9600XT-vel aztán X800 pro-val folytattam, majd X1950XT, ekkor egy kis stop, jött az nVidia 8800GTX és a 8800GTX 320MB ment a gépembe, majd aztán szintén ATI, vagyis akkor már AMD HD4870 váltotta, aztán HD5850, HD7870, eztán lettem nVidiás, ha lehet ennek nevezni, de nagyot csalódtam az új RX 5700 XT-nek a drivereiben. Én kívánom, hogy taszítsák le a trónról az RTX 2080 TI-t azán meg jöjjön az árharc, essenek az árak, jöjjön egy új nVidia 3000-es széria, aztán rá RX 4000-es széria és püföljék egymást és az árakat lefele.

Kivégzést nem akarok, látjuk mi történt AMD CPU vonalon, már árulom az i5-9600k-mat, mert Ryzen-re szeretnék váltani. Sajnos az Intel-t elpüfölte az AMD csak nehogy elszálljanak az árral, ha ők veszik át a monopóliumot.

No mindegy, bocsánat a hosszú posztért! Csak hát izgalmas dolgok történnek mostanában.

Az nvidia és az AMD "shader" egységei nem raszterizálásra készültek, ezek általános számolók, csak nem a ray tracing szükségleteihez igazítva. Maga a raszterizálás a ROP blokkokon keresztül történik és ez meg is fog maradni a jövőben, mert egyelőre teljes RT megjelenítést nem fogunk látni. A most elérhető megoldások is csak hibrid leképezők vagy path tracing leképezők.

A unified shader architecture nem az nvidia találmánya, az AMD az XBox 360 GPU -ját már ilyen elven építette fel. Egy streaming multiprocessor nem volt egyenértékű egy pixel és egy vertex futószalag együttes teljesítményével, a lényeg az volt, hogy ezeken a számolókon egyszerre lehetett futtatni mindkét shader kódot az ütemezőn keresztül és megszűnt a megkötés a pixel és vertex shader arányai között, mivel ezek innentől virtualizálva futottak. Ez hívta életre a geometry shadert, ami mondhatni a két dolog együttes alkalmazása.

A konzolok visszafogó ereje inkább a hetedik generációban volt borzasztó erős, de nem szabad elfelejteni, hogy éppen ez a generáció teljesített ki egy csomó játékstílust és engedett utat az indie fejlesztőknek. Öröm az ürömben.

A mai nyolcadik generáció, főleg a generáción belüli fejlesztett modelleknek köszönhetően nem igazán fékezi a PC -t. A hardvervilág fejlődése eleve lelassult a gyártástechnológiai fejlesztés korlátai miatt és tíz éven belül elérjük azt a határt, ahonnan már nem nagyon tudunk lejjebb menni csíkszélességben.

Annak idején maga a működő konzumer 3D gyorsítás megjelenése volt (Voodoo 1996) a "csoda", és az első GeForce 256 kártya megjelenéséig (1999 DX7) csak a sebesség és a textúrázók száma változott. A GeForce behozta a T&L támogatást, ami masszív javulást eredményezett a megvilágításban, de újabb két évnek kellett eltelnie az első pixelárnyalók megjelenéséig (GeForce 3 2001 DX8). Innentől felépítésben nem történt olyan nagy változtatás az említett unified felépítés megjelenéséig, ami sokat számított, az a DirectX 9 (első sorban a DX9c). Itt jelentek meg olyan shaderek, amik valósághű megjelenítést tettek lehetővé. Igazság szerint az első unified GPU -k nem is voltak ilyen szempontból kihasználva, mivel a rendering pipeline DX9 -ben fixen be volt állítva pixel és vertex shaderek tekintetében és a G80 / G9x GPU -k jobban is szerepeltek ez alatt az API alatt. A DX9 után az első igazán jelentőségteljes változás a DX12 volt, a DX11 sok effektet hozott, de ezeket alig használták ki, mivel sok volt az API overhead. És ha ilyen szempontból nézzük a dolgot, akkor a G80 óta az első jelentőségteljes újítás a RT egységek bevezetése, holott a játékok grafikája azért a 8. konzolgeneráció megjelenésével ugrásszerűen javult, mostanra igazából tradicionális raszteres megjelenítésben is szinte fotórealisztikus.

Akkor ne cseréld le 😃 .