Az AMD bejelentette az RX Vega 64 és 56 videokártyákat

A SIGGRAPH-on az AMD leleplezte a végső információkat két kiemelkedő hardveréről. Az első a Ryzen Threadripper volt, most pedig a Vega 10-ről olvashattok.

A játékosok tűkön ülve vártak már az AMD Vega architektúrájára. A mainstream Polaris 2016 júniusi debütálása óta vártak egy új termékre, amely leváltja az R9 Fury X-et. Megérkeztek az első információk a Vega architektúráról, de semmi konkrétumot nem lehetett tudni egészen mostanáig, ugyanis az AMD Vega kártyái hamarosan megjelennek, és a cég részletes információval szolgált a termékeiről.

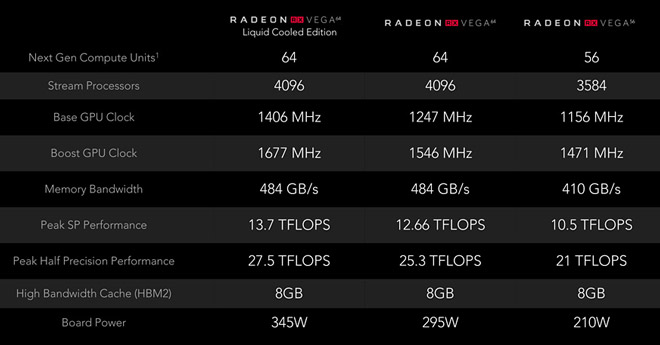

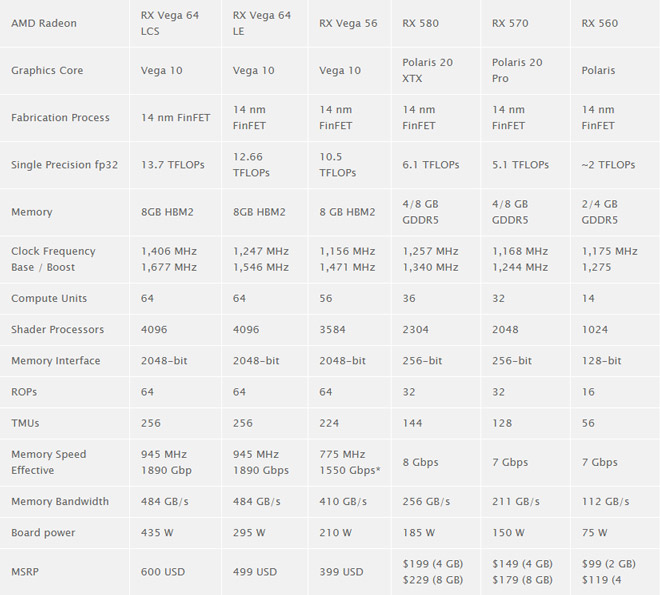

A Vega 10 egy nagy előrelépés lesz a cég számára. A Vega ugyanannyi stream processzorral rendelkezik, mint a Fiji, viszont sokkal nagyobb az órajele. Ha ezen kívül más nem változott volna, akkor a Vega 10 50%-kal lenne gyorsabb, de itt többről van szó, mint egyszerű órajel növelésről.

Az AMD sok időt belefektetett a HBCC (High-Bandwidth Cache Controller – nagy sávszélességű gyorsítótár vezérlő-be), ezzel optimalizálva a memória elérést. A kártyák 8 GB HBM2 memóriával rendelkeznek.

Az árazás első ránézésre elég jónak tűnik. Az RX Vega 64 kezdő ára 499 dollár, amely a levegőhűtéses videokártya ára, extrák nélkül, de folyadékhűtéssel rendelkező verzió is várható. A valamivel gyengébb RX Vega 56 pedig 399 dollárért lesz beszerezhető, amely nem sokkal marad le a 499 dolláros társától. Egy negyedik verzió is várható az év későbbi szakaszában.

Alternatív fűtésként még állami támogatást is lehet rá igényelni.😆

A BKK programozói közt az nvidia is szerepeltethetné a fejlesztőit. 😆

Ha pedig felteszem a programot akkor letiltja a videókártyát...

Puffin23: Akkor ez elsősorban a tápgyártó feladata, és csak másodsorban a vga gyártóé.

Ettől függetlenül szerintem is egy picit csalódás hogy ebből nem tudtak lefaragni egy kicsit.

alap, OC és extrém OC.Fassságot írtam: butított, alap, OC.Itt inkább az a kérdés, hogy ezen felül van-e még benne craft vagy ennyi és netovább.

A hőmérséklet meg értelem szerűen felkúszik mindkét gyártónál ~80°C körülig simán ha ekkora mértékű túlhúzásról van szó. Persze ez sok mindentől függ, valakinél több, valakinél kevesebb.

HD 5870-től R9 290-ig AMD-t használtam vga-ként, HD 7970-ig jók is voltak. De az R9 290 már borzalmas volt, pedig 2 is volt belőle. Tehát ha azt kéne mondanom, hogy HD 7970 vagy GTX 680, akkor HD 7970. De R9 290 vagy GTX 780, akkor GTX 780. Nem vagyok elvakult egyik irányba sem, se semmilyen gyártó felé, csak a tényeket nézem.

Az látszik hogy nem egy OC bajnok a Vega, és nem szégyenl fel venni több áramot, ellenben a 1080 sokkal jobban viseli a dolgot.

Nekem meg RX480-am van és 1.45Ghz-en megy jelenleg, nem tudom 60°C-nál jobban megizzasztani pedig nem keveset húztam rajta.

Spoiler!

Előtte meg HD7850-em volt, ami egy GTX650-et váltott ami az utolsó Nv kártyám volt, előtte egészen az MX440 megjelenése óta csak Nv-t használtam de megelégeltem a sok bloatware-t ami a cég fejlődése alatt felhalmozódott és az évenkénti kártya váltást mert idő előtt megdöglött valami (kimenet, cooler, elfüstölt, memó hiba stb...) vagy csak szimplán beesett a teljesítménye érthetetlen okokból...

Voltak jobb meg rosszabb szériák mindkét gyártónál. Volt jó Nv kártyám is amit imádtam, de volt olyan is ami elérte hogy váltsak.

Itt egy teszt a fogyasztásról. Sima 1080 Founders Ed. Crysis 3 alatt 335W-ot eszik.

Tudom hogy lehet belőle lefaragni így-úgy, nem arról van szó, csak rá akartam mutatni hogy attól hogy a gyártó rávés egy átlag TDP-t a kártyájára attól az még nem szentírás.

[LINK]

[LINK]

Viszont akkor itt egy másik 😃 ez már tényleg magát a kártyát mutatja, igaz már szintetikus teszt alatt 304W FurMarkban.

[LINK]

Ez meg a második linkről:

"I launched FurMark in stress test mode in 1024×768 and after 5 minutes, the GPU temperature reached 75°C while the total power consumption was 304W.

A rough approximation of the Strix GTX 1080 power consumption is (the power consumption of the CPU is around 20W): (304-44-20) * 0.9 = 216W"

Az nem a Frontier... 😃